Explore every episode of Modellansatz

| Pub. Date | Title | Duration | |||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 29 Sep 2016 | Erasmus | 00:35:32 | |||||||||||||||||

Vojtěch Cvrček ist im Herbst 2013 als Erasmusstudent von der CTU in Prag nach Karlsruhe ans KIT entsandt worden. Er hatte schon in der Grundschule Deutsch gelernt und wollte seine Sprachkenntnisse direkt in Deutschland verbessern. Deshalb wollte er auch ein ganzes Jahr bleiben (nicht nur ein Semester). Das bedeutete insbesondere, dass er die Einarbeitung in seine Masterarbeit schon in Karlsruhe beginnen müsste und deshalb ein Thema und ein Betreuerteam finden müsste, dass dies ermöglicht. Seine deutsche Wunschstadt war eigentlich Berlin - wegen der räumlichen Nähe zur Prag und weil ihm die Stadt gut gefiel. Leider gab es im Rahmen des Erasmusprogrammes aber keine Möglichkeit für ihn, dort sein Mathematikstudium fortzuführen. Infrage kamen dafür nur die TU Hamburg, TU Darmstadt und das KIT in Karlsruhe. Unter seinen Professoren und Mitstudenten in Prag war das KIT in Karlsruhe nicht gut bekannt, aber ein ordentlicher Fußballverein war in seinen Augen ein Pluspunkt für Karlsruhe. Nach der Entscheidung für Karlsruhe suchte er nach persönlichen Ansprechpartnern. Er fand die Projekte von Matthias Krause im Internet und ihn begeisterte insbesondere die dort vorgestellte Zusammenarbeit der Mathematik mit dem studentischen Projekt KAraceing. Deshalb schrieb er Matthias Krause eine e-mail und stellte sich als künftiger Erasmusstudent vor, der den einen oder anderen Rat einholen wollen würde. Er fand ein offenes Ohr und geeignete Lehrveranstaltungen wurden entsprechend seinen Zielen für das Jahr in Karlsruhe zusammengestellt. Für die Zeit in Karlsruhe und darüber hinaus hatte er damit einen Mentor, der ihn schließlich auch in seine Arbeitsgruppe integriert hat. Vojtěch Cvrček wurde studentische Hilfskraft und unterstützte Matthias Krause zunächst in der Lehre bis er in der Lage war, das Softwareprojekt OpenLB mit weiter zu entwickeln. Die Gruppenmeetings des Teams um OpenLB gehörten selbstverständlich zu seiner Arbeit und der Austausch in der Gruppe war dadurch sehr intensiv. Deshalb sieht Vojtěch Cvrček das Jahr in Karlsruhe als das beste Jahr in seinem Studium an. Er hat hier sehr viel gelernt und tolle Unterstützung durch Mitstudierende gefunden. Als Vorlesungen entschied er sich für Mathematische Modellbildung und Simulation in der Praxis, Partielle Differentialgleichungen, das Projektorientierte Praktikum, Inverse Probleme und Paralleles Rechnen. Anschließend stand die Vorbereitung der Masterarbeit zum Thema Mischung von nichtnewtonschen Fluiden im Vordergrund. Nichtnewtonsche Fluide finden sich überall, z.B. auch in der Medizin (hier vor allem das Fluid Blut). Seine Professor in Prag hat schon lange Beziehung zum Institut für experimentelle Medizin, deshalb war dieses Thema für beide Seiten (Karlsruhe und Prag) sehr interessant. Seine Vorkenntnisse und der Wunsch, die deutschen Sprache wirklich zu sprechen, erwiesen sich als Vorteil, weil Vojtěch Cvrček so leichter Kontakte knüpfen konnte zu den deutschen Studierenden und Mitarbeitern. Nach einer Anfangszeit mit einer Unterkunft am Stadtrand von Karlsruhe konnte er im Studentenwohnheim HaDiKo (kurz für Hans-Dickmann-Kolleg) einziehen, was einem reichhaltiges sozialen Leben zur Folge hatte und auch vielen Kontakten zu nicht-Mathematikern. Nach erfolgreichem Abschluss des Studiums in Prag wollte er gern in Deutschland eine Arbeit als Ingenieur finden. Dafür hat er auch die Karrieremessen des KIT genutzt, um direkt Kontakt zu Firmen zu knüpfen. Das hat schließlich dazu geführt, dass er sogar die Wahl zwischen verschiedenen Angeboten hatte. Er wird nun als Mathematiker im Maschinenbau tätig sein in der Nähe von Karlsruhe. Referenzen:

| |||||||||||||||||||

| 06 Oct 2016 | Robots | 00:20:36 | |||||||||||||||||

This is another conversation Gudrun had during the British Applied Mathematics Colloquium which took place 5th – 8th April 2016 in Oxford. Since 2002 Anette Hosoi has been Professor of Mechanical Engineering at MIT (in Cambridge, Massachusetts). She is also a member of the Mathematical Faculty at MIT. After undergraduate education in Princeton she changed to Chicago for a Master's and her PhD in physics. Anette Hosoi wanted to do fluid dynamics even before she had any course on that topic. Then she started to work as Assistant Professor at MIT where everyone wanted to build robots. So she had to find an intersection between fluid and roboters. Her first project were Robo-snailes with her student Brian Chan. Snails move using a thin film of fluid under their foot (and muscles). Since then she has been working on the fascinating boundary of flow and biomechanics. At the BAM Colloquium she was invited for a plenary lecture on "Marine Mammals and Fluid Rectifiers: The Hydrodynamics of Hairy Surfaces". It started with a video of Boston dynamics which showed the terrific abilities some human-like robots have today. Nevertheless, these robots are rigid systems with a finite number of degrees of freedom. Anette Hosoi is working in control and fluid mechanics and got interested in soft systems in the context of robots of a new type. Soft systems are a completely new way to construct robots and for that one has to rethink everything from the bottom up.You are a dreamer she was told for that more than once. For example Octopuses (and snails) move completely different to us and most animals the classcallly designed robots with two, four or more legs copy. At the moment the investigation of those motions is partially triggered by the plausible visualization in computer games and in animated movie sequences. A prominent example for that is the contribution of two mathematicians at UCLA to represent all interactions with snow in the animated movie Frozen. The short verison of their task was to get the physics right when snow falls off trees or people fall into snow - otherwise it just doesn't look right. To operate robots which are not built with mechanical devices but use properties of fluids to move one needs valves and pumps to control flow. They should be cheap and efficient and without any moving parts (since moving parts cause problems). A first famous example for such component is a fluid rectifier which was patented by Nicola Tesla in the 1920ies. His device relied on inertia. But in the small devices as necessary for the new robots there are no inertia. For that Anette Hosoi and her group need to implement new mechnisms. A promising effect is elasticity - especially in channels. Or putting hair on the boundary of channels. Hair can cause asymmetric behaviour in the system. In one direction it bends easily with the flow while in the opposite direction it might hinder flow. While trying to come up with clever ideas for the new type of robots the group found a topic which is present (almost) everywhere in biology - which means a gold mine for research and open questions. Of course hair is interacting with the flow and not just a rigid boundary and one has to admit that in real life applications the related flow area usually is not small (i.e. not negligible in modelling and computations). Mathematically spoken, the model needs a change in the results for the boundary layer. This is clear from the observations and the sought after applications. But it is clear from the mathematical model as well. At the moment they are able to treat the case of low Reynolds number and the linear Stokes equation which of course, is a simplification. But for that case the new boundary conditions are not too complicated and can be treated similar as for porous media (i.e. one has to find an effective permeability). Fortunately even analytic solutions could be calculated. As next steps it would be very interesting to model plunging hairy surfaces into fluids or withdrawing hairy surfaces from fluids (which is even more difficult). This would have a lot of interesting applications and a first question could be to find optimal hair arrangements. This would mean to copy tricks of bat tongues like people at Brown University are doing. References

| |||||||||||||||||||

| 05 Apr 2018 | Singular Pertubation | 00:21:57 | |||||||||||||||||

Gudrun had two podcast conversations at the FEniCS18 workshop in Oxford (21.-23. March 2018). FEniCS is an open source computing platform for solving partial differential equations with Finite Element methods. This is the first of the two episodes from Oxford in 2018. Roisin Hill works at the National University of Ireland in Galway on the west coast of Ireland. The university has 19.000 students and 2.000 staff. Roisin is a PhD student in Numerical Analysis at the School of Mathematics, Statistics & Applied Mathematics. Gudrun met her at her poster about Balanced norms and mesh generation for singularly perturbed reaction-diffusion problems. This is a collaboration with Niall Madden who is her supervisor in Galway. The name of the poster refers to three topics which are interlinked in their research. Firstly, water flow is modelled as a singularly perturbed equation in a one-dimensional channel. Due to the fact that at the fluid does not move at the boundary there has to be a boundary layer in which the flow properties change. This might occur very rapidly. So, the second topic is that depending on the boundary layer the problem is singularly perturbed and in the limit it is even ill-posed. When solving this equation numerically, it would be best, to have a fine mesh at places where the error is large. Roisin uses a posteriori information to see where the largest errors occur and changes the mesh accordingly. To choose the best norm for errors is the third topic in the mix and strongly depends on the type of singularity. More precisely as their prototypical test case they look for u(x) as the numerical solution of the problem for given functions b(x) and f(x). It is singularly perturbed in the sense that the positive real parameter ε may be arbitrarily small. If we formally set ε = 0, then it is ill-posed. The numercial schemes of choice are finite element methods - implemented in FEniCS with linear and quadratic elements. The numerical solution and its generalisations to higher-dimensional problems, and to the closely related convection-diffusion problem, presents numerous mathematical and computational challenges, particularly as ε → 0. The development of algorithms for robust solution is the subject of intense mathematical investigation. Here “robust” means two things:

In order to measure the error, the energy norm sounds like a good basis - but as ε^2 → 0 the norm → 0 with order ε . They were looking for an alternative which they found in the literature as the so-called balanced norm. That remains O(1) as ε → 0. Therefore, it turns out that the balanced norm is indeed a better basis for error measurement. After she finished school Roisin became an accountant. She believed what she was told: if you are good at mathematics, accountancy is the right career. Later her daughter became ill and had to be partially schooled at home. This was the moment when Roisin first encountered applied mathematics and fell in love with the topic. Inspired by her daughter - who did a degree in general science specialising in applied mathematics - Roisin studied mathematics and is a PhD student now (since Sept. 2017). Her enthusiasm has created impressive results: She won a prestigious Postgraduate Scholarship from the Irish Research Council for her four year PhD program. References

Podcasts

| |||||||||||||||||||

| 12 Apr 2018 | Wasserstofftankstellen | 00:46:56 | |||||||||||||||||

Gudrun unterhielt sich mit Meike Juliane Amtenbrink. Frau Amtenbrink hat von September 2017 bis Februar 2018 am Fraunhofer Institut für Solare Energiesysteme (ISE) in Freiburg Wasserstofftankstellen modelliert. Die Niederschrift der Ergebnisse bilden ihre Masterarbeit im Studiengang Energietechnik am KIT . Gudrun hat die Arbeit von Seiten des KIT als Erstgutachterin betreut. Als kohlenstofffreier Energieträger ist Wasserstoff im weltweiten Fokus der Forschung. Tanken mit Wasserstoff verspricht, den CO2-Ausstoß des Verkehrssektors zu reduzieren, zusätzlich ermöglicht die Umwandlung überschüssiger Strommengen in Wasserstoff mittels Elektrolyse dringend benötigte Flexibilität für die zukünftige Energieversorgung. Dafür müssen Tankstellen zur Verfügung stehen. Auf dem noch jungen Markt hat sich auf der Kundenseite bereits ein Standard etabliert, sodass alle Besitzerinnen eines Brennstoffzellenfahrzeugs an jeder Wasserstofftankstelle nachtanken können. Der technische Aufbau der Tankstellentechnologie ist dabei, je nach Anwendung, unterschiedlich. Teil der Arbeit war es einzuschätzen, welche Konzepte für den zukünftigen Markt eine Rolle spielen. Aufgrund der Vergleichbarkeit zwischen den relevanten Konzepten und dem in der ISE-eigenen Tankstelle umgesetzten Aufbau, wurde die institutseigene Tankstelle modelliert und die vorhandenen Messdaten genutzt, um die Plausibilität der Ergebnisse zu überprüfen. Im Rahmen vorangegangener Abschlussarbeiten wurde am Fraunhofer ISE ein Simulationsmodell eines Power-to-Gas-Systems auf Basis der PEM-Elektrolyse erstellt. Dieses Modell hatte zum Ziel, das dynamische Systemverhalten nachzubilden, Aussagen/Vorhersagen zum realen Wirkungsgrad der Anlage zu geben und die tatsächliche jährliche Wasserstofferzeugung zu prognostizieren. Darauf konnte Frau Amtenbrink aufbauen. In ihrer Arbeit wurde ein nulldimensionales, thermodynamisches Realgasmodell einer Wasserstofftankstelle in MATLAB/Simulink erstellt. Dafür wurden für die Einzelkomponenten einer Wasserstofftankstelle die Enthalpie- und Stoffbilanzen aufgestellt, in Simulink implementiert und über eine Steuerungslogik zu einem Gesamtsystem verbunden. Mit dem Tankstellenmodell können das Stand-by-Verhalten der Tankstelle und der Betankungsvorgang sekundengenau simuliert werden. Ergebnis sind die Drücke, Temperaturen und Stoffströme des Wasserstoffs an den relevanten Stellen im Gesamtsystem und der Energieverbrauch der Tankstelle, aufgeschlüsselt nach den wichtigsten Einzelkomponenten. Das Speichermodell kann auf Grundlage der Erhaltungsgleichungen über die zu- und abfließenden Stoffströme den sich ergebenden Druck und die Temperatur des Wasserstoffs im Speicher nachbilden, wobei die Realgasgleichung nach Redlich und Kwong benutzt wurde. Der Wärmeaustausch mit der Umgebung durch Konvektion und Wärmeleitung ist berücksichtigt. Das Modell ist auf verschiedene Speicher parametrisierbar und kann über die Anpassung der Geometrie- und Materialwerte sowohl für die Druckbänke an der Tankstelle, als auch für den Fahrzeugtank genutzt werden. Die Speichermodelle zeigen eine sehr gute Übereinstimmung mit der Realität. Die Drücke in Abhängigkeit der Umgebungstemperatur und die Temperaturerhöhung, die sich als Resultat einer Speicherbefüllung ergibt, können nachgebildet werden, ebenso der nach einer Befüllung erfolgende Temperaturausgleich mit Druckreduzierung. Durch das Modell für die Rohrleitungen können die Druckverluste innerhalb der Tankstelle abgebildet werden. Das Modell ist durch die Wahl der Geometrieparameter auf unterschiedliche Tankstellenkonfigurationen anwendbar. Der Kompressor wurde isentrop modelliert und die Verdichtungsarbeit mit einem isentropen Wirkungsgrad korrigiert. Der Druckanstieg, der sich durch den Kompressor beim Wiederbefüllen der Druckbank ergibt, ist durch die Simulation genau wiedergegeben. Dadurch ergibt sich, dass die Dauer der Speicherbefüllung zwischen Simulation und Messung übereinstimmt. Zur Modellierung der Kältemaschine wurde der Kältemittelkreislauf stark vereinfacht und durch eine Kälteleistung ersetzt, die von der Umgebungstemperatur abhängt. Für die wichtigsten Energieverbraucher an der Tankstelle, Kompressor und Kältemaschine, wurden Modelle erstellt, durch die der Energieverbrauch in Abhängigkeit der Betriebsführung berechnet werden kann. Nach der anschließenden Validierung kann das Modell dazu dienen, die Hauptenergieverbräuche an der Tankstelle zu quantifizieren und die Größe der einzelnen Komponeten optimal aufeinander auszulegen. Damit kann in Zukunft entschieden werden, ob zum Beispiel die Betriebsführung der Kältemaschine zur Optimierung des Gesamtwirkungsgrades verändert werden sollte. Literatur und weiterführende Informationen

Podcasts

| |||||||||||||||||||

| 19 Apr 2018 | Zweiphasenströmungen | 00:45:47 | |||||||||||||||||

Gudrun hatte zwei Podcast-Gespräche beim FEniCS18 Workshop in Oxford (21.-23. März 2018). FEniCS ist eine Open-Source-Plattform zur Lösung partieller Differentialgleichungen mit Finite-Elemente-Methoden. Dies ist die zweite der beiden 2018er Folgen aus Oxford. Susanne Claus ist zur Zeit NRN Early Career Personal Research Fellow an der Cardiff University in Wales. Sie hat sich schon immer für Mathematik, Physik, Informatik und Ingenieursthemen interesseirt und diese Interessen in einem Studium der Technomathematik in Kaiserlautern verbunden. Mit dem Vordiplom in der Tasche entschied sie sich für einen einjährigen Aufenthalt an der Universität Kyoto. Sie war dort ein Research exchange student und hat neben der Teilnahme an Vorlesungen vor allem eine Forschungsarbeit zu Verdunstungsprozessen geschrieben. Damit waren die Weichen in Richtung Strömungsrechnung gestellt. Dieses Interesse vertiefte sie im Hauptstudium (bis zum Diplom) an der Uni in Bonn, wo sie auch als studentische Hilfskraft in der Numerik mitarbeitete. Die dabei erwachte Begeisterung für nicht-Newtonsche Fluid-Modelle führte sie schließlich für die Promotion nach Cardiff. Dort werden schon in langer Tradition sogenannte viskoelastische Stoffe untersucht - das ist eine spezielle Klasse von nicht-Newtonschem Fluiden. Nach der Promotion arbeitet sie einige Zeit als Postdoc in London am University College London (kurz: UCL) zu Fehleranalyse für Finite Elemente Verfahren (*). Bis sie mit einer selbst eingeworbenen Fellowship in der Tasche wieder nach Cardiff zurückkehren konnte. Im Moment beschäftigt sich Susanne vor allem mit Zweiphasenströmungen. In realen Strömungsprozessen liegen eigentlich immer mindestens zwei Phasen vor: z.B. Luft und Wasser. Das ist der Fall wenn wir den Wasserhahn aufdrehen oder die Strömung eines Flusses beobachten. Sehr häufig werden solche Prozesse vereinfacht modelliert, indem man sich nur eine Phase, nämlich die des Wassers genau ansieht und die andere als nicht so wichtig weglässt. In der Modellbildung für Probleme, in denen beide Phasen betrachtet werden sollen, ist das erste Problem, dass das physikalische Verhalten der beiden Phasen sehr unterschiedlich ist, d.h. man braucht in der Regel zwei sehr unterschiedliche Modelle. Hinzu treten dann noch komplexe Vorgänge auf der Grenzflächen auf z.B. in der Wechselwirkung der Phasen. Wo die Grenzfläche zu jedem Zeitpunkt verläuft, ist selbst Teil der Lösung des Problems. Noch interessanter aber auch besonders schwierig wird es, wenn auf der Grenzfläche Tenside wirken (engl. surfactant) - das sind Chemikalien die auch die Geometrie der Grenzfläche verändern, weil sie Einfluß auf die Oberflächenspannung nehmen. Ein Zwischenschritt ist es, wenn man nur eine Phase betrachtet, aber im Fließprozess eine freie Oberfläche erlaubt. Die Entwicklung dieser Oberfläche über die Zeit wird oft über die Minimierung von Oberflächenspannung modelliert und hängt deshalb u.a. mit der Krümmung der Fläche zusammen. D.h. man braucht im Modell lokale Informationen über zweite Ableitungen. In der numerischen Bearbeitung des Prozesses benutzt Susanne das FEniCS Framework. Das hat sie auch konkret dieses Jahr nach Oxford zum Workshop geführt. Ihr Ansatz ist es, das Rechengitter um genug Knoten anzureichern, so dass Sprünge dargestellt werden können ohne eine zu hohe Auflösung insgesamt zu verursachen. (*) an der UCL arbeitet auch Helen Wilson zu viscoelastischen Strömungen, mit der Gudrun 2016 in Oxford gesprochen hat. Literatur und weiterführende Informationen

Podcasts

| |||||||||||||||||||

| 26 Apr 2018 | CAMMP | 00:35:33 | |||||||||||||||||

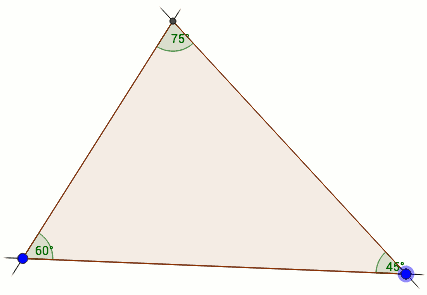

Gudrun hat sich mit Kirsten Wohak unterhalten. Sie ist seit Januar 2018 in der Arbeitsgruppe Computational Science and Mathematical Methods von Prof. Frank tätig. Diese Gruppe schlägt eine Brücke zwischen dem Steinbuch Center for Computing und der KIT-Fakultät für Mathematik. Thema des Gespräches war jedoch ein ganz besonderes Angebot für Schülerinnen und Schüler: Das Computational and Mathematical Modeling Program (CAMMP) . Zusammen mit Maren Hattebuhr kümmert sie sich um das schon an der RWTH Aachen erprobte Konzept nun auch in Karlsruhe. Beantwortet wird die Frage: Wie funktionieren eigentlich...

... und was hat das mit Mathe zu tun? Anhand solchen praxisorientierter Fragestellungen aus dem eigenen Alltag werden Schüler und Schülerinnen in die Grundlagen der mathematischen Modellierung eingeführt. Dabei finden mathematische Inhalte, wie beispielsweise Winkelsätze oder Matrizenrechnung Anwendung, die bereits aus dem Unterricht bekannt sind. Neben inhaltlicher Arbeit werden in den Workshops vor allem prozessbezogene Kompetenzen gefördert. Das typische Format ist ein sogenannter CAMMP-day. Er findet jeweils am Schülerlabor Mathematik im Mathebau statt und wird auf Anfrage je nach Themenwahl mit Oberstufen- bzw. Mittelstufenkursen von ein bis zwei wissenschaftlichen Mitarbeitern/-innen durchgeführt. Seit dem 23. April 2018 läuft für sechs Montage der Schnupperkurs Mathematik zum Thema GPS und Navigation und am heutigen Girls' day findet der Shazam-Kurs statt. Podcasts

| |||||||||||||||||||

| 17 May 2018 | Computergrafik | 00:36:32 | |||||||||||||||||

Das Treffens des German Chapters of European Women in Mathematics fand am 3. und 4. Mai 2018 im Mathematikon in Heidelberg statt. Am Rande der Konferenz der Mathematikerinnen sprach Gudrun mit Susanne Krömker. Sie leitet seit 2004 die Computergrafik-Gruppe des Interdisziplinären Zentrums für Wissenschaftliches Rechnen(IWR) an der Ruprecht-Karls-Universität Heidelberg. In der Computergrafik geht es grob gesagt um Analyse und Bearbeitung von Daten und ihre Darstellung als visuelle Information, d.h. es kommen sehr viele unterschiedliche Anforderungen zusammen. Andererseits sind die Themen, die jeweils dahinter stecken auch ganz besonders vielgestaltig. Für Susanne begann 1989 die Faszination mit der Darstellung einer reaktiven Strömung, bei der explosionsartig Wärme freigesetzt wird. Im Experiment ist die Apparatur geborsten, die Simulation liefert die Erklärung durch eine von den Wänden reflektierte Druckwelle und die Visualisierung macht den zeitlich enorm kurzen Explosionsvorgang mit Temperatur- und Druckverteilung im reaktiven Gemisch anschaulich.

Anschließend hat sie sich in ihrer Promotion mit partiellen Differentialgleichungen zur Beschreibung katalytischer Prozesse an Oberflächen beschäftigt, sich aber nie ganz von dem Thema Computergrafik getrennt, das in den 1990er Jahren dann richtig Fahrt aufnahm. Heute ist die Computergrafik technisch gesehen eine typische Anwendung für Hochleistungsrechnen. Außerdem gibt es immer wieder interessante Entwicklungen, die die Möglichkeiten von Grafikkarten unkonventionell ausnutzen. Aber es geht auch darum, geeignete Methoden zu entwicklen und zu implementieren, mit denen die von 3D-Scannern erfassten Messdaten auf ihren Informationsgehalt reduziert werden können. Grundsätzlich müssen dabei immer dreidimensionale Vorgänge auf dem zweidimensionalen Bildschirm dargestellt werden. Dazu braucht man projektive Geometrie - ein Thema, das in der Vorlesung mitunter abstrakt und von der Realität weit entfernt scheint. In ihrer Geometrie-Vorlesung für Sudierende der Mathematik kann Susanne ihre Erfahrungen aus der Informatik sehr anschaulich einbringen wie hier im Video für die Fano Ebene: (YouTube) Etwa seit dem Jahr 2000 gab es in der Arbeitsgruppe von Susanne viele besonders interessante und sehr unterschiedliche Projekte. Ein Forschungsschwerpunkt lag dabei in der Kombination von Computertomographie und Oberflächendaten, um aus beiden Bildgebungsverfahren im Resultat ein verbessertes Bild zu erhalten: ILATO-Projekt (Improving Limited Angle computed Tomography by Optical data integration). Außerdem hat sich die enge Zusammenarbeit mit Archäologen, Historikern und Geologen als besonders fruchtbar erwiesen. Beispiele dafür sind der theoriebildende Diskurs zum digitalen Modell des Klosters Lorsch (seit 1991 Weltkulturerbe der UNESCO) oder die Rekonstruktion von Inschriften in Tafeln und auf Grabsteinen, z.B. auf dem jüdischen Friedhof in Worms. Diese Analyse basiert auf Multiskalen Integralinvarianten, einem Filterverfahren, das in dem Softwareframework GigaMesh (Autor: Hubert Mara, IWR, Universität Heidelberg) implementiert ist. Oder die Rekonstruktion der Karten von barocken Globen, u.a. des Gottorfer Globus, mit HiIfe von anisotrop diffusiver Filterung. Die Arbeitsgruppe hat Ausgrabungen im Tempelgebiet von Angkor in Kambodscha, dem größten Tempelgebiet der Welt, wissenschaftlich begleitet. Es gelang eine virtuelle architektonische Rekonstruktion des größten Tempels Angkor Wat oder die Rekonstruktion einer sechs Meter hohen Schiva-Statue aus Koh Ker, von der einzelne Puzzle-Teile über mehrere Museen der Welt verstreut sind. Susanne hatte sich 1983 zunächst für ein Studium der Mathematik und Betriebswirtschaft in Osnabrück entschieden, hat dann aber den Wechsel nach Heidelberg verbunden mit der Hinwendungen zu anderen Natur- und Geisteswissenschaften nie bereut. Literatur und weiterführende Informationen

| |||||||||||||||||||

| 03 Oct 2013 | Mathematische Modellbildung | 00:37:21 | |||||||||||||||||

Gudrun Thäter spricht mit Sebastian Ritterbusch über Mathematische Modellbildung und die zugehörige Vorlesung im Studium, über überraschende Ventile, dem Stau aus dem Nichts und Fußgängersimulationen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 10 Oct 2013 | Die Aorta-Challenge | 00:36:08 | |||||||||||||||||

Thomas Henn spricht mit Sebastian Ritterbusch über seine Blutflusssimulationen in der Aorta, die mathematische Beschreibung, wie man über ein Becken geht, numerische Simulationen auf einem Großrechner und über den internationalen Vergleich der Ergebnisse. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 17 Oct 2013 | Unsichtbarkeit | 00:42:23 | |||||||||||||||||

Andreas Helfrich-Schkarbanenko befasst sich mit der mathematischen Beschreibung der Unsichtbarkeit, Metamaterialien und berichtet im Gespräch mit Sebastian Ritterbusch über Simulationsexperimente zu akustischen und elektromagnetischen Tarnkappen. Zusammen mit Muamer Kadic und Philipp Klas passten sie eine Tarnkappe an ein inhomogenes Hintergrundmedium an. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 24 Oct 2013 | Erdölsuche | 01:00:49 | |||||||||||||||||

Jörg Bäuerle hat ein Verfahren zur verbesserten Erdölsuche erforscht, das passiv die elektromagnetische Ausstrahlung von Erdölfeldern auswerten kann. Wie im Gespräch mit Sebastian Ritterbusch zu hören, steckt darin viel Mathematik, Freude über L-Kurven und nicht nur ein inverses Problem. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 31 Oct 2013 | Pumpspeicherkraftwerke | 00:42:44 | |||||||||||||||||

Julia Dickmann optimiert den Betrieb von Pumpspeicherkraftwerken ohne die Zukunft der Strompreise und Regenfälle genau zu kennen. Dazu geht sie im Gespräch mit Sebastian Ritterbusch auf Zeitreise aus der Zukunft in die Gegenwart, und berechnet so mit Topologiematrix und Simplex-Verfahren optimale Steuerungsstrategien auf Basis von statistischen Modellen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 07 Nov 2013 | Computertomographie | 00:35:38 | |||||||||||||||||

Yuemin Liang hat Methoden entwickelt, mit denen Bewegungen während einer Computertomographie herausgerechnet werden können, um bessere Rekonstruktionen zu erhalten. Dafür verwendet sie Marker, die im Sinogramm verräterische Spuren zeigen, wenn es zu Bewegungen gekommen ist, kann so die ungewollten Bewegungen zum Teil kompensieren, und erklärt das Ganze im Gespräch mit Sebastian Ritterbusch. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 14 Nov 2013 | Ad-hoc Netzwerke | 01:01:14 | |||||||||||||||||

Leonid Chaichenets hat Ad-hoc Netze modelliert, und dadurch die Optimierung der erfolgreichen Übertragungen ermöglicht. Er erklärt im Gespräch mit Sebastian Ritterbusch wie mit Verfahren aus der stochastischen Geometrie in Zukunft bessere Kommunikationsnetze für Notkräfte entwickelt werden können. Ein besonderes Merkmal der Netze ist, dass einzelne Teilnehmer nichts über ihre Kommunikationspartner wissen. Wie soll es funktionieren, dass nicht alle versuchen gleichzeitig zu senden? Mit einer geschickten Aloha Strategie kann man alleine aus dem Verhalten der Teilnehmer die Qualität des Netzes im Voraus berechnen und damit die Gesamtleistung optimieren. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 21 Nov 2013 | Injektoren | 00:29:17 | |||||||||||||||||

Carmen Straub modelliert und simuliert den Einspritzvorgang im Motorraum durch Injektoren. Dabei hat sie das Modell und die numerischen Verfahren auf Stabilität untersucht indem sie numerische Lösungen mit einer analytischen Lösung verglich. Um den Einsatz neuer Forschungsergebnisse um Large-Eddy-Simulationen zu untersuchen hat sie das Modell mit einem neuen Softwarepaket gekoppelt. Diese Ergebnisse wurden mit einem echten Einspritzvorgang verglichen. Dabei hat sie auch viel mit Ingenieuren in Deutschland und USA zusammengearbeitet und Forschung in der Industrie kennengelernt, und erzählt uns davon im Gespräch mit Gudrun Thäter. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 05 Dec 2013 | Positionsbestimmung | 00:35:17 | |||||||||||||||||

Hakan Demirel hat die Positionsbestimmung auf der Erde untersucht, wie sie zum Beispiel mit dem Global Positioning System möglich ist. Dabei geht er im Gespräch mit Gudrun Thäter auch auf Fehlerquellen ein, die auf sehr unterschiedliche Arten, die bestimmte Position verfälschen können, und wie Blitze verortet werden können. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 12 Dec 2013 | Flammen | 00:18:13 | |||||||||||||||||

Auch Flammen können durch partielle Differentialgleichungen modelliert werden, und Robin Trunk hat so ein Modell mit Hilfe von Level-Set Methoden numerisch mit Finiten Elementen simuliert. Im Gespräch mit Gudrun Thäter geht er auch auf die Zusammenarbeit mit den Ingenieuren am IKET und das Studium der Technomathematik ein. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 19 Dec 2013 | Erdbeben | 00:37:57 | |||||||||||||||||

Erdbeben lassen sich nicht verhindern, doch wir lernen immer besser mit ihnen umzugehen. Dafür simuliert Stephanie Wollherr die Erdschwingungen und erklärt im Gespräch mit Gudrun Thäter, wie wir mit optimaler Versuchsplanung bessere Aufstellorte für Seismographen bestimmen können. Durch das Modell in schwacher Formulierung und Optimierung des Messnetzes mit Fisher-Informationsmatrix erhalten wir ein genaueres Bild über die physikalischen Vorgänge in der Erde und letztlich eine bessere Grundlage für Vorhersagen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 09 Jan 2014 | Strömungssteuerung und Gebietszerlegung | 00:20:10 | |||||||||||||||||

Luftströmungen sorgen für den Auftrieb von Flugzeugen, und sind zu großem Teil durch den Luftwiderstand für den Treibstoffverbrauch im Auto verantwortlich. Deswegen untersucht Eva Ketelaer, wie man mit Finiten Elementen Strömungen simulieren und optimal steuern kann, und erläutert im Gespräch mit Gudrun Thäter auch, wie man die Verfahren auch auf Hochleistungsrechner mit Zerlegungsmethoden skalieren kann. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 30 Jan 2014 | Windsimulation im Stadtgebiet | 00:46:41 | |||||||||||||||||

Irina Waltschläger modelliert den Wind im Stadtgebiet, um die Luftbewegung ausgehend von einem Gebäude- und Geländemodell mit den Navier-Stokes Gleichungen als Fluid simulieren und analysieren zu können. Im Gespräch mit Sebastian Ritterbusch erklärt sie, wie sie dazu künstliche Randbedingungen auf der Basis meteorologischer Erkenntnisse zum Windprofil entworfen hat, und deren Einfluss auf die Simulation analysierte. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 06 Feb 2014 | Lawinen | 00:16:36 | |||||||||||||||||

Lawinen und Muren sind im alpinen Bergland allgegenwärtige Gefahren, daher ist die Simulation des Abgangs gerade für Anwohner und Versicherungen sehr wichtig. Auf Basis eines Geländemodell aus dem Grass GIS Geoinformationssystem hat Katharina Schratz das mathematische Modell numerisch umgesetzt, und geht im Gespräch mit Sebastian Ritterbusch auf die Besonderheiten der Diskretisierung und der speziellen CFL-Bedingungung für numerische Stabilität ein. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 13 Feb 2014 | Lärmschutz | 00:32:08 | |||||||||||||||||

Der Autoverkehr macht Lärm, und vor diesem möchte man die Umwelt mit Lärmschutzwänden oder Lärmschutzwällen schützen. Tilo Arens erklärt im Gespräch mit Sebastian Ritterbusch, wie man die Schallausbreitung mit der Helmholtz-Gleichung mathematisch modellieren kann und durch das Huygens-Prinzip mit Randelementen und Integralgleichungen simulieren kann. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 20 Feb 2014 | Migräne | 01:54:51 | |||||||||||||||||

Das Gehirn ist nicht nur eine graue Substanz, sondern ein sehr komplexes Organ, wo es noch viel zu erforschen gibt. Markus Dahlem befasst sich mit der Migräne, und erklärt im Gespräch mit Gudrun Thäter und Sebastian Ritterbusch, wie hier mit Modellbildung im Gehirn neue Erkenntnisse erzielt werden: Migräne ≠ Kopfschmerzen, auf diese einfache Formel kann man es bringen. Denn Migräne ist eine Krankheit, Kopfschmerz ein Symptom. Kopfschmerzen sind nicht einmal notwendiges Merkmal dieser Volkskrankheit, die, je nach Detailtiefe der Diagnose, in bis zu 19 Unterformen klassifiziert werden kann, eine davon ohne Kopfschmerzen dafür mit visuellen Halluzinationen, die man Aura nennt. Laut der neusten Studie der Weltgesundheitsorganisation über die globale Gesundheitsbelastung ist Migräne weltweit für fast 3% der Behinderungen verantwortlich. Damit befindet sich Migräne an achter Stelle der am schwersten belastenden Krankheiten und auf dem ersten Platz unter den neurologischen Erkrankungen. Wie kann hier die Mathematik helfen? Der Verlauf einer Migräne mit Aura ist kennzeichnend für einen bestimmten Mechanismus raum-zeitlicher Strukturen. Solche Strukturen zum Beispiel in Form lokalisierter Wellensegmente sind in der Musterbildung aus Reaktion-Diffusions-Systemen vom Aktivator-Inhibitor-Typ bekannt. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 27 Feb 2014 | Sicherheitsventile | 00:22:53 | |||||||||||||||||

Sicherheitsventile sollen uns durch eine geeignete Auslegung vor Explosionen und Unglücken wie dem Sevesounglück in der Industrie schützen. Doch sind die aktuellen Sicherheitsrichtlinien zeitgemäß? Andreas Schleich hat dazu ein Sicherheitsventil mathematisch modelliert und mit der Lattice-Boltzmann Methode den Betrieb mit numerischer Fluid-Simulation simuliert. Dazu verwendete er ein Large-Eddy Modell zur Turbulenzmodellierung und validierte die Methode mit dem Strömungswiderstandskoeffizient (cW-Wert) einer Metallkugel. Im Gespräch mit Sebastian Ritterbusch erzählt er auch über Vakuumbläschen und andere Herausforderungen in der Simulation. Literatur und Zusatzinformationen

| |||||||||||||||||||

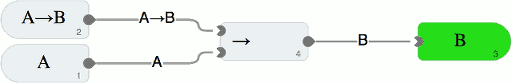

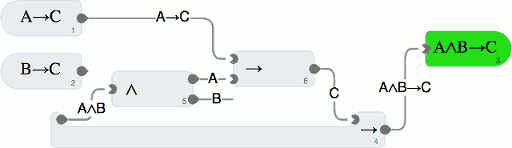

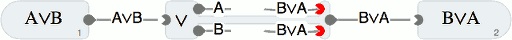

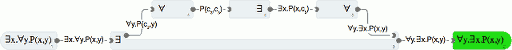

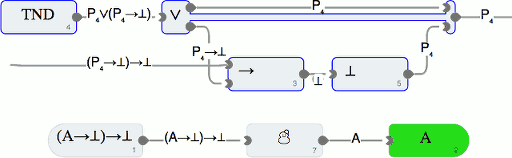

| 17 Apr 2014 | Computerunterstütztes Beweisen | 00:40:30 | |||||||||||||||||

Dagmar Rütters führt im Gespräch mit Gudrun Thäter die Technik ein, Computer unterstützte Beweise zu führen. Eine große Rolle spielt hierbei eine mathematisch korrekte Berechnung aller Größen, die zum Beispiel durch Intervallarithmetik möglich wird . Literatur und Zusatzinformationen

| |||||||||||||||||||

| 24 Apr 2014 | Zeitreihen | 00:32:50 | |||||||||||||||||

Zeitreihen erleben wir bei Aktienkursen, seismischen Messungen, Wetterbeobachtungen, Wahlen und vielem mehr. Franziska Lindner befasst sich deshalb mit der Zeitreihenanalyse und wie man mit mathematischen Methoden und Statistik Aussagen über die Struktur der Zeitreihen, Ereignisse im Zeitverlauf und Prognosen mit Konfidenzbereichen bestimmen kann. Im Gespräch mit Gudrun Thäter erläutert sie das Prinzip der Stationarität und den Einsatz der Fourieranalyse und das statistische Resampling in der Zeitreihenanalyse. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 15 May 2014 | Chromatographie | 00:49:25 | |||||||||||||||||

Tobias Hahn simuliert mit einem Konvektions-Diffusions-Modell die Makrokinetik in einer Chromatographie-Säule zur Isolation und Analyse von Proteinen und Antikörper für verbesserte Medikamente und viele weitere bio-chemische Produkte. Im Gespräch mit Gudrun Thäter erklärt er, wie Simulationen die Chromatographie verbessern und die Anzahl von Experimenten verringern. Eine besonders wichtige Anwendung ist auch die Parameterschätzung von unbekannten Größen aus durchgeführten Experimenten, wo durch das Fitting der Simulation an die gemessenen Daten die einzelnen Prozesse analysiert werden können. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 22 May 2014 | Versuchsplanung | 00:31:26 | |||||||||||||||||

Mit Differentialgleichungsmodellen werden oft zeitliche und/oder räumliche Prozesse modelliert, beispielsweise auch enzymatisch katalysierte Reaktionen. Anna Osberghaus schildert im Gespräch mit Gudrun Thäter, wie sie in ihrer Diplomarbeit mit Hilfe von Modelldiskriminierung unter den möglichen Reaktionswegen eines bestimmten Enzyms den wahrscheinlichsten bestimmt hat und danach mittels optimaler Versuchsplanung Experimente entworfen hat, die die Entscheidung für einen bestimmten Reaktionsweg in Zukunft vereinfachen sollten. Nebenbei schildert sie humorvoll und ehrlich ihren Werdegang von einer an "echten Daten" interessierten Mathematikstudentin zum PostDoc im Ingenieurwesen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 05 Jun 2014 | Gasspeicher | 00:40:15 | |||||||||||||||||

Um Gasspeicher mit möglichst viel Gewinn zu betreiben, verwendet Viola Riess Markov-Prozesse, um mit statistischen Methoden und durch mathematische Modelle optimale Handelsstrategien zu berechnen. Dabei muss sie neben Vorhersagemodellen für den Gaspreis auch die Restriktionen des Speichers in Füllstand und Kapazität berücksichtigen. Im Gespräch mit Gudrun Thäter erklärt sie die Diskretisierung des stochastischen Prozesses in ein Gitter, und die Rückwärtsinduktion zur Bewertung der Strategie, wie wir sie auch schon im Podcast zu Pumpspeicherkraftwerken kennengelernt hatten. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 12 Jun 2014 | Wasserstraßen | 00:35:10 | |||||||||||||||||

An der Bundesanstalt für Wasserbau (BAW) befasst sich Rebekka Kopmann in der Abteilung für Flusssysteme mit Analysen und Prognosen des Systemzustands von Bundeswasserstraßen. Strömungsmodelle liegen am BAW sowohl als nachgebaute Modelle von Flussstücken als auch als mathematisch beschriebene Computermodelle vor, die nur im Rechner simuliert werden. Im Gespräch mit Gudrun Thäter beschreibt sie die Herausforderung der Kalibration der Simulationsmodelle an die Wirklichkeit, damit sinnvolle Analysen und Prognosen möglich werden. Neben vielen weiteren Parametern ist die Rauheit im Fluss sehr wichtig und ist leider nur sehr zeitaufwendig zu bestimmen. Die Aufgabe führt sie auf ein Optimierungsproblem zurück, wo die unbekannten Parameter durch Annäherung vielfach ausgeführter Simulationen an die gemessene Wirklichkeit bestimmt werden. Da eine einzelne Flusssimulation teilweise tagelang rechnet, sucht sie nach sinnvollen Vereinfachungen oder Alternativen, die das Problem schneller lösen. Aktuell werden Methoden der Automatischen Differentiation eingesetzt, die helfen Gradientenverfahren zur Annährung an die Lösung zu beschleunigen. Dabei trifft man auch auf interdisziplinäre Herausforderungen, wenn es um die feinen mathematischen Unterschiede zum Beispiel zwischen Ableitung, Steigung und einem Gradienten geht. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 26 Jun 2014 | Predictive Analytics | 00:32:45 | |||||||||||||||||

Bei Blue Yonder, einem führenden Lösungsanbieter im Bereich Prognosen und Mustererkennung in Europa, arbeitet Florian Wilhelm an verschiedenen Kundenprojekten und spricht darüber mit Gudrun Thäter. Ein konkretes Beispiel sind Absatzprognosen für einen Kunden im Einzelhandel. Mit diesen Prognosen kann der Disponent eine optimale Entscheidung treffen wie viele Produkte er von einem Großhändler kauft, um bei hoher Warenverfügbarkeit möglichst geringe Abschreibungen durch verdorbene Ware zu haben. Zur Generierung dieser Prognosen werden sowohl Methoden aus dem Bereich des Maschinellen Lernens wie auch der Statistik angewendet. Manche Methoden haben ihren Ursprung in der Teilchenphysik, wo sie verwendet werden um Teilchen in den Experimenten am CERN nachzuweisen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 03 Jul 2014 | Last-Call Auktionen | 00:18:45 | |||||||||||||||||

Last-Call Auktionen sind Auktionen, in denen ein Bieter bevorzugt wird. Marie-Christin Haufe beschäftigt sich in ihrer Diplomarbeit mit dieser Auktionsform und untersucht, wie sich die Vergabe eines Last-Call Rechts auf das Bietverhalten der nichtbevorzugten Bieter auswirkt. Dabei werden spieltheoretische Gleichgewichte berechnet, ökonomisch interpretiert und ihre Auswirkungen auf den erwarteten Auktionserlös mathematisch analysiert. Im Gespräch mit Gudrun Thäter erklärt sie, wie sie mit der Modellierung durch die Betaverteilung Aussagen über die Bieterstärken, Wertschätzung und der Aggressivität im Auktionsprozess sowohl als Erstpreisauktion als auch in einer Zweitpreisauktion treffen konnte. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 17 Jul 2014 | Wahlsysteme | 00:25:08 | |||||||||||||||||

Wahlsysteme definieren den Ablauf von Wahlen, und wie daraus ein Wahlergebnis bestimmt wird. Dieses Ergebnis soll die oft sehr unterschiedlichen Vorstellungen der Wählenden möglichst gut repräsentieren. Philipp Staudt hat dazu mathematisch analysiert, wie das deutsche Wahlsystem gegenüber alternativen Verfahren wie der Rangaddition und der Condorcet-Methode abschneidet. Ein besonderes Augenmerk lag im Gespräch mit Gudrun Thäter auch auf der Frage, wie die 5 Prozent-Klausel unter verschiedenen Voraussetzungen das Ergebnis beeinflusst. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 24 Jul 2014 | Getriebeauswahl | 00:25:33 | |||||||||||||||||

Getriebe sind mechanische Komponenten, die oft zwischen Motoren und anzutreibenden Maschinenteilen zum Einsatz kommen, und übersetzen Drehmomente und Drehzahlen. Für einen Anwendungsfall gibt es aber viele einsetzbare Getriebe mit vielen weiteren Eigenschaften, wie Wirkungsgrad, Geräuschentwicklung, Größe, Gewicht und vieles mehr. Jonathan Fröhlich hat hier die Frage betrachtet, wie man bei der Auswahl des Getriebes vorgehen kann, und erklärt im Gespräch mit Gudrun Thäter, wie hier der Analytic Hierarchy Process den Entscheidungsprozess durch die Berechnung von Eigenwerten und Eigenvektoren unterstützen kann. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 31 Jul 2014 | Unfallvorhersage | 00:27:02 | |||||||||||||||||

Aus einem Verkehrsmodell kann man den Straßenverkehr simulieren und damit mögliche Staustellen und auch die Gefahr für Verkehrsunfälle vorhersagen. Dafür wird das Straßennetz in ein Netzwerk aus Knoten und Kanten zerlegt, und mit stochastischen Methoden aus früheren Messungen Aussagen über die Zukunft getroffen und Auswirkung von Änderungen analysiert. Marianne Petersen hat dazu den Verkehr im Rhein-Main-Gebiet betrachtet und beschreibt im Gespräch mit Gudrun Thäter, wie sie mit Bayes-Verfahren, Regressionsanalyse und Poisson-Verteilungen gerade auch seltene Unfallereignisse analysieren konnte. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 07 Aug 2014 | Motorisches Lernen | 00:48:04 | |||||||||||||||||

Kinder erlernen das Laufen und Schreiben im Spiel, doch für Erwachsene ist es nach z.B. einem Schlaganfall eine ganz andere Herausforderung. Daher untersucht Christian Stockinger im BioMotion Center das motorische Lernen, damit wir besser verstehen können, wie sich der Körper sensormotorische Programme abruft. Mit einem Robotic Manipulandum, dem BioMotionBot, lässt er dazu die Probanden einfache Armbewegungen durchführen, die unbemerkt durch ein Kraftfeld gestört werden. Dadurch erlernen sie unbemerkt neue Bewegungsabläufe, und im Gespräch mit Gudrun Thäter erklärt er, wie man diesen Lernvorgang mathematisch mit einem Zwei-Prozessmodell beschreiben kann. Daraus kann man sowohl viel über die Vorgänge lernen, Therapien verbessern, als auch die Entwicklung von modernen Prothesen und humanuider Roboter voranbringen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 14 Aug 2014 | Matrixfunktionen | 00:25:04 | |||||||||||||||||

Eine Funktion, die eine Matrix auf eine Matrix abbilden kann, ist eine Matrixfunktion. Diese Funktionen finden besonders bei der numerischen Behandlung von Evolutionsgleichungen wie zum Beispiel der Wärmeleitungsgleichung ihre Anwendung. Dazu bändigt Tanja Göckler die komplizierten partiellen Differentialgleichungen, die aus der mathematischen Modellbildung entstehen, durch Diskretisierung und weiteren Methoden zu gewöhnlichen Differentialgleichungen. Diese können durch Potenzreihen gelöst werden, die auch als Matrixfunktionen eingesetzt werden können. So kann man beispielsweise auch die Exponentialfunktion als Potenzreihe auf eine Matrix anwenden, um lineare Differentialgleichungen zu lösen. Im Gespräch mit Gudrun Thäter erklärt sie, wie man diese Aufgaben aber mit rationalen Krylov-Verfahren noch viel effizienter lösen kann. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 21 Aug 2014 | Digitale Währungen | 02:22:18 | |||||||||||||||||

Um im digitalen Umfeld elektronischen Handel zu betreiben, benötigt man einen gesicherten Datenaustausch für Angebote, Verhandlungen und Verträge, aber letztlich auch eine Form von elektronischem Geld auf dem der Handel basiert. Ganz zentral ist dabei die moderne Kryptographie und insbesondere die Public Key-Verfahren, die durch mathematische Verfahren das ganze ermöglichen, soweit die Verfahren sicher, korrekt implementiert und richtig benutzt werden, und es nicht zu einem Fiasko wie dem Heartbleed-Bug kommt. Im Gespräch mit Gudrun Thäter erläutert Sebastian Ritterbusch die Mathematik hinter digitalem Geld und der Kryptowährung Bitcoin. Dazu geht es zunächst in die Zahlentheorie der Restklassenkörper Literatur und Zusatzinformationen

| |||||||||||||||||||

| 11 Sep 2014 | Logistik und Big Data | 00:14:10 | |||||||||||||||||

Im Bereich der Logistik geht es um die fortlaufende Optimierung des Geschäftsprozesses und dies kann man inzwischen auf Basis einer großen Menge von teilweise komplex strukturierten Echtzeitdaten, kurz gesagt Big Data, umsetzen. Liubov Osovtsova hat dazu ein Modell der Transportlogistik auf Basis von Petri-Netzen in CPN Tools in der Form eines Coloured Petri Net aufgestellt. Im Gespräch mit Gudrun Thaeter erklärt sie, wie sie damit unter Nutzung des Gesetz von Little und Warteschlagentheorie stochastische Aussagen über Engpässe und Optimierungspotentiale bestimmen konnte. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 18 Sep 2014 | Höhere Mathematik | 00:48:24 | |||||||||||||||||

Auch im Studium der Ingenieurswissenschaften steckt viel Mathematik: Diese spielt besonders am Anfang des Studiums der Fächer Maschinenbau, Verfahrenstechnik und Chemieingenieurwesen am KIT eine große Rolle, und Frank Hettlich begleitet mit seinem Team die Studienanfänger in der sogenannten Höheren Mathematik in den ersten drei Semestern. Dabei geht es ihm in den Vorlesungen nicht um die Vermittlung von Patentrezepten, sondern um den kreativen Umgang mit mathematischen Methoden, die für das weitere Studium eine große Rolle spielen werden.Um den Übergang von der Schulmathematik zur universitären Mathematik zu erleichtern, gibt es einen sehr gut besuchten zwei-wöchigen Vorkurs parallel zur Orientierungsphase vor dem eigentlichen Vorlesungsbeginn. Im Gespräch mit Gudrun Thäter erzählt er, dass es besonders wichtig ist, einfach den Stift wieder in die Hand zu nehmen und sich selbst an der Mathematik zu versuchen, um den Einstieg erfolgreich zu vollbringen. Dafür gibt es viele Übungen, anwendungsnahe Beispiele und Materialen, wie das Buch zur Mathematik, in das Frank Hettlich seine langjährigen Erfahrungen aus der Lehre einbringen konnte.Ganz wichtig ist es auch, die Begeisterung für das wissenschaftliche Vorgehen zu vermitteln, und die Studierenden zur Zusammenarbeit anzuregen. Letztlich gibt es aber auch Klausuren zur Mathematik, die zumindest in Karlsruhe eher weniger den Grund für einen Studienabbruch liefern. Keinesfalls sollten sie aber die leichte Schulter genommen werden, und auch dazu hat Frank Hettlich einige wichtige Tipps: Zeitplanung, Zusammenarbeit und Vorsicht im Umgang mit Lösungen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 16 Oct 2014 | Leistungsstrukturanalyse im Triathlon | 00:29:53 | |||||||||||||||||

Die wissenschaftliche Fundierung des sportlichen Trainings kann sowohl im Amateur- als auch im Profibereich zur Verbesserung der individuellen Leistung beitragen. Marian Hoffmann ist Mitarbeiter des BioMotion Centers und beschäftigt sich mit dem Einsatz multivariater Verfahren zur Identifikationen leistungsrelevanter Einflussgrößen durch Strukturgleichungsmodelle in der Sportart Triathlon. Hierzu zählen beispielsweise Kraft- und Ausdauerfähigkeiten sowie technische und taktische Merkmale. Im Gespräch mit Gudrun Thäter erläutert er den Einsatz mathematischer Methoden zur Bearbeitung dieser interdisziplinären Aufgabenstellung mit dem Ziel, spezifische Trainingsempfehlungen auf Basis einer Leistungsstrukturanalyse in dieser Ausdauersportart generieren zu können. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 06 Nov 2014 | Analysis und die Abschnittskontrolle | 02:13:59 | |||||||||||||||||

Im Herbst beginnen die neuen Studiengänge der Mathematik am KIT und neben den Vorlesungen zur Linearen Algebra, Stochastik oder Numerik gehört die Analysis zu den mathematischen Vorlesungen, mit dem das Studium der Mathematik in den ersten Semestern beginnt. Dazu spricht Sebastian Ritterbusch mit Johannes Eilinghoff, der im letzten Jahr den Übungsbetrieb der Analysis-Vorlesungen mit großem Anklang organisiert hat. Die Analysis befasst sich besonders mit der Mathematik um Funktionen auf reellen Zahlen, welche Eigenschaften sie haben, und wie man diese differenzieren oder integrieren kann. Vieles zur Geschichte der Analysis findet man besonders in den Büchern von Prof. Dr. Michael von Renteln, der unter anderem über die Geschichte der Analysis im 18. Jahrhundert von Euler bis Laplace, die Geschichte der Analysis im 19. Jahrhundert von Cauchy bis Cantor, über Aspekte zur Geschichte der Analysis im 20. Jahrhundert von Hilbert bis J. v. Neumann und über die Die Mathematiker an der Technischen Hochschule Karlsruhe 1825-1945 geschrieben hat. Grundlage für die Mathematik in der Analysis sind die Zahlenmengen, wie die abzählbaren natürlichen Zahlen Ein Beispiel für eine Folge rationaler Zahlen, die gegen eine irrationale Zahl konvergieren ist Über den Begriff der Folge kann man auch offene Mengen und abgeschlossene Mengen definieren, so wie dies auch mit Epsilon-Umgebungen definiert werden kann. Diese Eigenschaften werden im Bereich der mathematischen Topologie noch viel umfassender eingeführt, aber schon diese Darstellungen helfen, den wichtigen Begriff der Funktion in der Analysis und deren Eigenschaften einzuführen. Zur Definition einer Funktion gehört neben der eigentlichen Abbildungsvorschrift die Angabe der Definitionsmenge und der Wertebereich. Ohne diese Informationen ist es nicht möglich Surjektivität und Injektivität nachzuweisen. Eine wichtige Eigenschaft von Funktionen ist der Begriff der Stetigkeit, die man für den Zwischenwertsatz benötigt. Damit kann man zum Beispiel wackelnde Tische reparieren oder mit Anastasia im Science Slam Orte gleicher Temperaturen auf der Erde suchen. Der Zwischenwertsatz gilt zunächst nur für reelle Funktionen, es gibt den Zwischenwertsatz aber auch in allgemeinerer Form. Eine weitere wichtige Eigenschaft von Funktionen ist die Differenzierbarkeit und das Berechnen von Ableitungen mit ihren Ableitungsregeln. Sehr wichtig ist dabei die Exponentialfunktion, die mit ihrer eigenen Ableitung übereinstimmt. Diese Funktion findet man im Alltag in jeder Kettenlinie in der Form des Cosinus Hyperbolicus wieder. Eine wichtige Anwendung für differenzierbare Funktionen ist der Mittelwertsatz, ohne den die Abschnittskontrolle auf Autobahnen zur Geschwindigkeitsüberprüfung nicht denkbar wäre. Aber auch in höheren Dimensionen kann man Differentialrechnung betreiben, und man führt dazu den Gradienten, Richtungsableitungen und z.B. die Divergenz eines Vektorfelds ein. Als Umkehrung der Differentiation erhält man die Integralrechnung. Jedoch ist das Bilden einer Stammfunktion nur bis auf eine Konstante eindeutig. Daher kann man zum Beispiel mit Beschleunigungssensoren im Handy nicht wirklich eine Positions- und Geschwindigkeitsmessung durchführen, sondern muss für die Trägheitsnavigation viele weitere Sensoren mit einbeziehen. Eine andere Einführung des Integrals ist das Lebesgue-Integral oder das Riemannsche Integral, wo man bei letzterem in einem Intervall die Fläche unter einer Kurve durch Treppenfunktionen annähert. Den Zusammenhang dieser beiden Begriff liefert der Fundamentalsatz der Analysis. Leider kann man nicht zu allen Funktionen analytische Stammfunktionen bestimmen. Hier kann dann die numerische Integration zum Einsatz kommen. Die Integration ist aber keine rein abstrakte Idee, sondern wir finden mathematische Zusammenhänge wie den Gaußsche Integralsatz direkt in der Natur wieder. Für den Start im Studium erhält man in Karlsruhe viel Unterstützung: Es gibt Vorkurse und die von der Fachschaft für Mathematik und Informatik organisierte Orientierungsphase, oder kurz O-Phase, in der man die zukünftigen Mitstudierenden kennenlernen kann. Mit diesen sollte man sich gemeinsam den Stoff von Vorlesungen, Übungen und Tutorien erarbeiten, um sich mit gelösten Übungsblättern zur Klausteilnahme zu qualifizieren, und letztlich auch die Prüfungen gemeinsam vorzubereiten. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 13 Nov 2014 | Metallschaum | 01:39:52 | |||||||||||||||||

In den Materialwissenschaften ist man immer auf der Suche nach neuen Werkstoffen und Materialien. Sehr vielversprechend sind dabei Metallschäume, dessen Wärmeleitungseigenschaften Anastasia August am Institut für angewandte Materialien erforscht und über die sie uns im Gespräch mit Sebastian Ritterbusch erzählt. Zu den besonderen Eigenschaften von Metallschäumen gehören unter anderem die große Oberfläche bzw. Grenzfläche im Verhältnis zum Volumen wie bei Lungenbläschen und die hohe Wärmeleitungsfähigkeit im Verhältnis zum Gewicht. Gleichzeitig können Metallschäume mit Luft oder anderen Materialien wie Paraffin gefüllt werden, um besondere Eigenschaften zu erhalten. Neben Bierschaum ist auch der Badeschaum eine Möglichkeit Schäume mit ihrem außergewöhnlichem Verhalten kennenzulernen. Das geschäumte Materialgemisch erhält dabei aber typischerweise nicht durchschnittliche Materialeigenschaften, sondern es können Eigenschaften der einzelnen Materialien teilweise kombiniert werden; z.B. erhält ein Metall-Paraffinschaum eine recht hohe Wärmeleitfähigkeit vom Metall gepaart mit einer hohen Wärmekapazität und vor Allem mit einem günstigen Schmelzpunkt (45-80°C) vom Paraffin und ist damit ein sehr effizienter Latentwärmespeicher. In der Natur finden sich Schaumstrukturen zum Beispiel in Knochen, die bei hoher Stabilität ein deutlich geringeres Gewicht als ein massives Material haben. Aber auch für Knochenimplantate sind Metallschäume aus Titan durch die hohe Stabilität bei geringem Gewicht und guter Verträglichkeit sehr interessant. Problematisch ist für den Einsatz von Metallschäumen, dass noch viele quantitative Messgrößen fehlen, die Herstellung noch recht teuer ist, und insbesondere nur in kleinen Größen produziert werden kann. Als Unterscheidungsmerkmal hat sich neben der Unterscheidung in offen oder geschlossen porigen Schaum die ppi-Zahl als Maß für die Porendichte etabliert, dabei zählt man die Poren pro Inch (Zoll, entspricht 2,54 cm). Dazu erfasst man auch die mittlere Porengröße (Durchmesser), ihre Standardabweichung, die Porosität, die mittlere Stegdicke und deren Form. Weiterhin können sich Größen in verschiedenen Richtungen im Material unterscheiden, und dadurch merklich deren Eigenschaften verändern. Für die Herstellung von Metallschäumen gibt es unterschiedliche Verfahren: Zwei typische Vertreter sind das Pressen mit dem anschließenden Schmelzen von gemischtem Metall- und Metallhybridpulvern für geschlossen porige feste Schäume oder Gießverfahren, wo der Metallschaum für offen porige Materialien durch keramische Negativabbildungen von Polyurethan-Schäumen nachempfunden wird. Schon früh waren Schäume als möglichst dichte Packungen ein Forschungsfeld in der Mathematik. Im Jahr 1994 haben Weaire-Phelan eine noch optimalere regelmäßige Schaumstruktur veröffentlicht, die in der Architektur des zu den olympischen Sommerspielen 2008 in Peking errichteten Nationalen Schwimmzentrums verewigt wurde. Das ebenfalls zu den Sommerspielen errichtete Vogelnest hat im Gegenteil eine zufälligere Struktur. Lange hatte man keine verlässlichen Aussagen über die Wärmeleitfähigkeit von Metallschäumen. Bei einer Leitfähigkeit von etwa 200 W/(mK) von Aluminium erreicht ein Metallschaum Leitfähigkeiten zwischen 5-13 W/(mK) während man bei Luft von einer Leitfähigkeit von etwa 0.025 W/(mK) ausgehen kann. Außerdem haben Metallschäume einen hohen Oberflächenanteil, dies bezeichnet die vorhandene Oberfläche im Verhältnis zum Volumen. Während ein voller Metallwürfel ein Verhältnis von etwa Eine interessante Fragestellung ist auch, ab welcher Porengröße die natürliche Konvektion in mit Luft gefüllten Metallschäumen eine Rolle gegenüber der Wärmeleitung spielt. Die relevante Größe ist hier die Rayleigh-Zahl, die für Metallschäume typischer Porengrößen ergibt, dass die natürliche Konvektion zu vernachlässigen ist. Für die Simulation wird der komplette Raum des Metallschaums diskretisiert, und es gibt eine Funktion, die als Indikatorfunktion anzeigt, ob an diesem Punkt Metall oder Luft vorliegt. Hier können sowohl aus an der Hochschule Pforzheim durchgeführten Schnitten rekonstruierte Schaumstrukturen abgebildet werden, aber auch künstlich mit Algorithmen erzeugte Schäume für die Simulation abgebildet werden. Bei der künstlichen Erzeugung von Schäumen ist die Voronoi-Zerlegung ein wichtiger Algorithmus zur Bestimmung der Poren. Den eigentlichen Wärmetransport im Metallschaum wird durch die Wärmeleitungsgleichung Die Phasenfeldmethode und die Software Pace3D stammt ursprünglich aus der Simulation von Erstarrungs- und Schmelzvorgängen auf der Mikrometerskala. Metalle erstarren in Form von sogenannten Dendriten. Das sind Kristalle, die eine gewisse Ähnlichkeit mit Schneeflocken aufweisen. Eine interessante Anwendung von Metallschäumen bietet das mutige Silent Power PC Projekt, in dem ein Metallschaum den einen Rechner effizient kühlen soll. Aus den bisherigen Erkenntnissen der Arbeitsgruppe ist anzunehmen, dass ein Großteil der Kühlleistung in einem solchen System auf der Wärmeleitung liegt - für einen Einfluss der natürlichen Konvektion scheint die Porengröße zu klein zu sein. Die Faszination für Wissenschaft inspiriert Anastasia August nicht nur in der Forschung, sondern sie demonstriert sie auch auf Science Slams und im FameLab. Sie hielt dort Vorträge über ihr Forschungsgebiet und auch über das sehr unterschätzte Thema der Stetigkeit und die Anwendung auf Temperaturen auf der Erdkugel. Mit dem Vortrag auf dem Science Slam Vorentscheid in Esslingen zu Metallschäumen hat sie sich für die Meisterschaft am 6. Dezember qualifiziert. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 20 Nov 2014 | Graphpartitionierung | 00:35:51 | |||||||||||||||||

Ein Graph ist eine Menge von Knoten und Kanten zwischen diesen Knoten. Man unterscheidet zwischen gerichteten Graphen, wo Einbahnstraßen darstellbar sind, oder den ungerichteten Graphen, wo Beziehungen zwischen zwei Knoten immer beidseitig sind. Beispiele sind die graphische Darstellung von Beziehungen in einem sozialen Netz oder Straßennetze, für deren Verarbeitung das Forschungsgebiet von Christian Schulz immer bedeutender wird, wie wir in seinem Gespräch mit Gudrun Thäter erfahren. Eine wichtige Aufgabe im Umgang mit Graphen ist die Aufteilung (oder fachsprachlich Partitionierung), von Graphen in kleinere Teile. Dies kommt z.B. der Parallelisierung der Arbeit auf den Graphen zugute, und ist unumgänglich, wenn Graphen eine Größe haben, die nicht mehr von einem Prozessor bearbeitet werden kann. Ein wichtiges Merkmal ist hier, die Aufteilung möglichst gleichmäßig vorzunehmen, damit die Aufteilung von z.B. Rechenzeit gleichmäßig erfolgt, und gleichzeitig wenig Kommunikation zwischen der Bearbeitung der Einzelteile erforderlich ist. Es geht um eine möglichst gute Skalierbarkeit der Graphverarbeitung. Ein wichtiges Anwendungsproblem ist die Routenplanung, bei der zwischen zwei Punkten auf der Erde die zeitlich kürzeste Verbindung berechnet werden soll. In der Informatik ist der Dijkstra-Algorithmus der passende Basis-Algorithmus für diese Aufgabe, doch er ist für große Graphen in seiner ursprünglichen Form sehr ineffizient. In Kombination mit einer passenden Graphpartitionierung und Algorithmen kann man das Verfahren deutlich effizienter ausführen und beschleunigen. Ein klassisches Verfahren zur Aufteilung ist das Mehrschichtverfahren über die Laplace-Matrix, wo ausgenutzt wird, dass zwischen den Eigenwerten der Matrix und der Schnittstruktur des Graphen enge Zusammenhänge bestehen. Dieses Verfahren wurde zum Mehrschichtverfahren für Graphen weiterentwickelt, bei dem in einer sogenannten Kontraktion benachbarte Knoten und parallele Kanten jeweils zusammengeführt werden, und der Graph zu einem kleinen und kantengewichteten Graph vereinfacht wird. Schließlich wird das Problem auf einem vereinfachten, groben Gitter gelöst, und dann jeweils mit lokalen Suchen auf feinere Graphen erweitert. Für die Kontraktion werden Heuristiken und Kantenbewertungsfunktionen verwendet. Ein weiterer Ansatz sind auch evolutionäre Algorithmen. Dabei wurde eine allgemeinere Umgebung geschaffen, die auf eine weite Klasse von Optimierungsproblemen angewendet werden kann. Die Graphentheorie ist natürlich auch Teil der diskreten Mathematik, und besonders berühmt ist auch das Traveling Salesperson Problem. Gleichzeitig ist das Thema aber auch in der Theoretischen Informatik, im Algorithm Engineering und in der Software-Entwicklung beheimatet. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 27 Nov 2014 | Systembiologie | 01:33:01 | |||||||||||||||||

Auf den Vorschlag von Henning Krause verbreiteten viele Forschende unter dem Hashtag #1TweetForschung ihr Forschungsthema in Kurzform. So auch Lorenz Adlung, der in der Abteilung Systembiologie der Signaltransduktion am Deutschen Krebsforschungszentrum in Heidelberg die mathematische Modellbildung für biologische Prozesse erforscht. Bei der Anwendung einer Chemotherapie leiden Krebspatienten oft unter Blutarmut. Hier kann neben der Bluttransfusion das Hormon Erythropoetin, kurz EPO, helfen, da es die körpereigene Erzeugung von roten Blutkörperchen (Erythrozyten) unterstützt. Leider ist EPO als Dopingmittel bekannt, und um dem Doping noch deutlicher Einhalt zu gebieten, wurde im November 2014 in Deutschland ein Entwurf eines Anti-Doping-Gesetz vorgelegt. Trotz gängigem Einsatz und erprobter Wirkung von EPO ist die genaue Wirkung von EPO auf Krebszellen nicht bekannt. Daher verfolgt Lorenz Adlung den Ansatz der Systembiologie, um im Zusammenwirken von Modellbildung und Mathematik, Biologie und Simulationen sowohl qualitativ und quantitativ analysieren und bewerten zu können. Vereinfacht sind rote Blutkörperchen kleine Sauerstoff-transportierende Säckchen aus Hämoglobin, die auch die rote Farbe des Bluts verursachen. Sie stammen ursprünglich aus Stammzellen, aus denen sich im Differenzierungs-Prozess Vorläuferzellen bzw. Progenitorzellen bilden, die wiederum durch weitere Spezialisierung zu roten Blutkörperchen werden. Da es nur wenige Stammzellen gibt, aus denen eine unglaubliche große Anzahl von Trillionen von Blutkörperchen werden müssen, gibt es verschiedene Teilungs- bzw. Proliferationsprozesse. Das Ganze ergibt einen sehr komplexen Prozess, dessen Verständnis zu neuen Methoden zur Vermehrung von roten Blutkörperchen führen können. Den durch Differenzierung und Proliferation gekennzeichnete Prozess kann man mathematisch beschreiben. Eine zentrale Ansichtsweise in der Systembiologie der Signaltransduktion ist, Zellen als informationsverarbeitende Objekte zu verstehen, die zum Beispiel auf die Information einer höheren EPO-Konzentration in der Umgebung reagieren. Von diesem Ansatz werden durch Messungen Modelle und Parameter bestimmt, die das Verhalten angemessen beschreiben können. Diese Modelle werden in Einklang mit bekannten Prozessen auf molekularer Ebene gebracht, um mehr über die Abläufe zu lernen. Die erforderlichen quantitativen Messungen basieren sowohl auf manuellem Abzählen unter dem Mikroskop, als auch der Durchflusszytometrie, bei der durch Streuung von Laserlicht an Zellen durch Verwendung von Markern sogar Aussagen über die Zelloberflächen getroffen werden können. Zusätzlich kann mit der Massenspektrometrie auch das Innere von Zellen ausgemessen werden. In diesem Anwendungsfall werden die mathematischen Modelle in der Regel durch gekoppelte gewöhnliche Differenzialgleichungen beschrieben, die Zell- oder Proteinkonzentrationen über die Zeit beschreiben. Die Differenzialgleichungen und deren Parameter werden dabei sowohl mit Messungen kalibriert, als auch mit den Kenntnissen in der Molekularbiologie in Einklang gebracht. Die Anzahl der Parameter ist aber oft zu hoch, um naiv auf geeignete zu den Messungen passende Werte zu gelangen. Daher wird unter anderem das Latin Hypercube Sampling verwendet, um schnell nahe sinnvollen Parameterwerten zu gelangen, die durch gradienten-basierte Optimierungsverfahren verbessert werden können. Die Basis für diese Art von Optimierungsverfahren ist das Newton-Verfahren, mit dem man Nullstellen von Funktionen finden kann. Ein wichtiger Aspekt im Umgang mit Messergebnissen ist die Berücksichtigung von Messfehlern, die auch vom Wert der Messung abhängig verstanden werden muss- denn nahe der Messgenauigkeit oder der Sättigung können die relativen Fehler extrem groß werden. Die Bestimmung der Modellparameter ist schließlich auch ein Parameteridentifikationsproblem, wo insbesondere durch eine Sensitivitätsanalyse auch der Einfluss der geschätzten Parameter bestimmt werden kann. Sowohl die Parameter als auch die Sensitivitäten werden mit den biologischen Prozessen analysiert, ob die Ergebnisse stimmig sind, oder vielleicht auf neue Zusammenhänge gedeuten werden können. Hier ist die Hauptkomponentenanalyse ein wichtiges Werkzeug, um zentrale beeinflussende Faktoren erfassen zu können. Ein wichtiges Ziel der Modellbildung ist die numerische Simulation von Vorgängen, die als digitale Experimente sich zu einem eigenen Bereich der experimentellen Forschung entwickelt haben. Darüber hinaus ermöglicht das digitale Modell auch die optimale Planung von Experimenten, um bestimmte Fragestellungen möglichst gut untersuchen zu können. Die Umsetzung auf dem Computer erfolgt unter anderem mit Matlab, R (The R Project for Statistical Computing) und mit der spezialisierten und freien Software D2D - Data to Dynamics. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 11 Dec 2014 | Topologie | 01:16:08 | |||||||||||||||||

Prof. Dr. Wolfgang Lück befasst sich am HIM (Hausdorff Research Institute for Mathematics) und dem Mathematisches Institut der Universität Bonn mit der Topologie von Mannigfaltigkeiten und Flächen wie auf einem Torus oder einer Kugel. Speziell für Kugeln und Kreise gibt es die Sphären-Notation Auch wenn Flächen lokal ähnliche Eigenschaften haben, kann die Situation global ganz anders aussehen: So unterscheidet sich die Vorstellung einer flachen Erde lokal nicht von der Kugelform der Erde, global sieht es aber ganz anders aus. Ebenso kennen wir auch jetzt noch nicht sicher die Topologie des Weltalls. Dazu beschränkt sich unser Vorstellungsraum oft auf drei Dimensionen, obwohl schon die relativistische Physik uns lehrt, unsere Umgebung als Raumzeit in 4 Dimensionen zu verstehen. Bei der Klassifikationen von Flächen auf unterschiedlichen Körpern verwendet man Homöomorphismen um ähnliche Flächen einander zuzuordnen, und letztlich unterscheiden sich die Flächenklassen dann nur noch durch die Anzahl der Löcher bzw. dem Geschlecht, was dann auch die Eigenschaften der Flächen bestimmt. Ein Weg das Geschlecht der Fläche zu bestimmen ist die Triangularisierung, eine andere Möglichkeit bietet die Analyse des Spektrums eines Operators wie dem Laplace-Operators, das auch in der Topologie von Graphen zum Einsatz kommen kann. Ein Beispiel für die Anwendung des Laplace-Operators ist die Wärmeleitungsgleichung, die zwar die lokalen Eigenschaften des Wärmetransports beschreibt, jedoch das Wärmegleichgewicht nach unendlicher Zeit die globalen Zusammenhänge beinhaltet. Ein wichtiger Begriff ist hier der Integralkern, der hilft Lösungen durch Integraloperatoren darzustellen. Ein wichtiger mathematischer Begriff ist dabei der Besonderes Interesse liegt in der Topologie auf Invarianten, wie der Fundamentalgruppe, mit der man auch den Fundamentalsatz der Algebra beweisen kann. Ein weiteres Beispiel für eine Invariante ist die Windungszahl, die gerade in der Funktionentheorie zum Residuensatz und effizienten Integralberechnungsmethoden führt. Dabei entstehen oft nicht kommutative Verknüpfungen, wie man es zum Beispiel von der Matrizenmultiplikation oder den Symmetriegruppen kennen kann. Ein elementarer Einstieg in die Topologie ist auch über die Knotentheorie möglich, wo ebenso Knoten-Invarianten gefunden werden können, und über zum Beispiel Jones-Polynome klassifiziert werden können. Im weiteren Gespräch geht es um Themen wie die unterschiedlichen Bilder der Mathematik in Gesellschaft, Schule und Universität, die Bedeutung der Mathematik für Gesellschaft, die Ausbildung für Industrie und das Lehramt, und über den Stand und Möglichkeiten der Gleichberechtigung und Förderung von Frauen in der Wissenschaft. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 18 Dec 2014 | Risikobewertung | 00:26:41 | |||||||||||||||||

Prof. Dr. Wolfgang Härdle war im Rahmen des Workshop zu High Dimensional, High Frequency and Spatial Data in Karlsruhe und sprach mit Gudrun Thäter über sein Forschungsgebiet. Er befasst sich an der Humboldt-Universität zu Berlin mit der Bewertung von Risiken und ist am Lehrstuhl der Nachfolger von Ladislaw Bodjevich, der unter anderem für seine Arbeiten zum Gesetz der kleinen Zahlen berühmt geworden ist: Es sagt aus, dass auch wenn alle 37 Roulette-Zahlen gleich wahrscheinlich sind, nach 37 Würfen im Durchschnitt nur etwa 2/3 der Zahlen aufgetreten sind. Damit steht es nur scheinbar in gewissem Kontrast zum Gesetz der großen Zahlen, das bestimmt, wie die Auftrittshäufigkeit sich für viele Würfe der Gleichverteilung annähert. Das Flanken-Maß ist eine Eigenschaft von Profit and Loss (PnL, GuV)-Funktionen oder Zufallsvariablen, die die Dicke von Flanken oder Entferntheit von seltenen Ereignissen modelliert. Schon Ladislaw Bodjevich hat erkannt, dass das die Bewertung von Extremrisiken und wenige vorhandene Daten einen Widerspruch darstellt. Die Normalverteilung ist die Grenzverteilung gewichteter Zufallsgrößen, wenn der Grenzwert existiert, also bei vielen Ereignissen das Gesetz der großen Zahlen zum Einsatz kommen kann. Bei wenigen Ereignissen gelangt man zur Poisson-Verteilung. Obwohl sie theoretisch viele Prozesse gut beschreiben sollte, funktioniert die Normalverteilung in der Realität aus vielen Gründen oft schlechter als erwartet: Sich verändernde Prozesse können Mischverhältnisse von an sich normal-verteilten Bestandteilen verändern, ebenso kann sich die Volatilität bzw. die Streuung um den Erwartungswert über die Zeit verändern. Es kann aber auch eine vollkommene andere Verteilung vorliegen wie zum Beispiel die Extremwertverteilung, Weibull-Verteilung mit algebraisch abfallenden Tails oder der Pareto-Verteilung. Leider ist die stochastische Konvergenz von Extermwertverteilungen sehr schlecht, und erschwert so Vorhersagen und Bewertungen. So wurden strukturierte Finanzprodukte mit multivariaten Modellen und einer Normalverteilungsannahme viel zu vereinfacht modelliert. So waren CDO-Produkte daher vor der Finanzkrise ab 2007 viel zu billig und hatten einen beträchtlichen Anteil an der Krise. Die Risikobewertung ist aber nicht nur für die Bewertung von Katastrophen-Bonds für Versicherungen gegen Erdbeben wichtig, sondern auch für die Analyse von EEG von Kindern. Sie hilft aber auch den Risikofaktor Mensch im Sinne der Behaviour Finance zu verstehen. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 25 Dec 2014 | Teichmüllerkurven | 00:48:06 | |||||||||||||||||

Jonathan Zachhuber war zum 12. Weihnachtsworkshop zur Geometrie und Zahlentheorie zurück an seine Alma Mater nach Karlsruhe gekommen und sprach mit Gudrun Thäter über Teichmüllerkurven. Kurven sind zunächst sehr elementare ein-dimensionale mathematische Gebilde, die über den komplexen Zahlen gleich viel reichhaltiger erscheinen, da sie im Sinne der Funktionentheorie als Riemannsche Fläche verstanden werden können und manchmal faszinierende topologische Eigenschaften besitzen. Ein wichtiges Konzept ist dabei das Verkleben von Flächen. Aus einem Rechteck kann man durch Verkleben der gegenüberliegenden Seiten zu einem Torus gelangen (Animation von Kieff zum Verkleben, veröffentlicht als Public Domain): Polynome in mehreren Variablen bieten eine interessante Art Kurven als Nullstellenmengen zu beschreiben: Die Nullstellen-Menge des Polynoms Auch wenn die entstehenden abstrakten Beschreibungen nicht immer anschaulich sind, so erleichtern die komplexen Zahlen den Umgang mit Polynomen in einem ganz wichtigen Punkt: Der Fundamentalsatz der Algebra besagt, dass der Grad des Polynoms gleich der Anzahl der Nullstellen in ihrer Vielfachheit ist. Also hat nun jedes nichtkonstante Polynom mindestens eine Nullstelle, und über den Grad des Polynoms wissen wir, wie viele Punkte sich in der Nullstellenmenge bewegen können, wenn wir an den Koeffizienten Veränderungen vornehmen. Eine gute Methode die entstehenden Flächen zu charakterisieren ist die Bestimmung möglicher geschlossener Kurven, und so gibt es beim Torus beispielsweise zwei unterschiedliche geschlossene Kurven. Die so enstehende Fundamentalgruppe bleibt unter einfachen Deformationen der Flächen erhalten, und ist daher eine Invariante, die hilft die Fläche topologisch zu beschreiben. Eine weitere wichtige topologische Invariante ist das Geschlecht der Fläche. Die Teichmüllerkurven entstehen nun z.B. durch das Verändern von einem Koeffizienten in den Polynomen, die uns durch Nullstellenmengen Kurven beschreiben- sie sind sozusagen Kurven von Kurven. Die entstehenden Strukturen kann man als Modulraum beschreiben, und so diesen Konstruktionen einen Parameterraum mit geometrischer Struktur zuordnen. Speziell entstehen Punkte auf Teichmüllerkurven gerade beim Verkleben von gegenüberliegenden parallelen Kanten eines Polygons; durch Scherung erhält man eine Familie von Kurven, die in seltenen Fällen selbst eine Kurve ist. Ein Beispiel ist das Rechteck, das durch Verkleben zu einem Torus wird, aber durch Scherung um ganz spezielle Faktoren zu einem ganz anderen Ergebnis führen kann. Die durch Verklebung entstandenen Flächen kann man als Translationsflächen in den Griff bekommen. Hier liefert die Translationssymmetrie die Methode um äquivalente Punkte zu identifizieren. Für die weitere Analyse werden dann auch Differentialformen eingesetzt. Translationen sind aber nur ein Beispiel für mögliche Symmetrien, denn auch Rotationen können Symmetrien erzeugen. Da die Multiplikation in den komplexen Zahlen auch als Drehstreckung verstanden werden kann, sind hier Rotationen als komplexe Isomorphismen ganz natürlich, und das findet man auch in den Einheitswurzeln wieder. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 08 Jan 2015 | Fußgänger | 00:25:44 | |||||||||||||||||

Auch Menschenströme können mathematisch beschrieben und mit geeigneten Modellen auch simuliert werden. Damit können große Veranstaltungen im Vorfeld besser geplant und ausgelegt werden, damit Engpässe oder sogar Katastrophen wie bei der Love-Parade 2010 möglichst verhindert werden. Henrieke Benner hat dazu die Parameter für die Simulation von Fußgängern im Gegenstrom kalibriert und spricht mit Gudrun Thäter über die Verfahren, Herausforderungen und Erkenntnisse. Mathematisch betrachtet sie die Fußgänger in einem mikroskopischen Modell, wo jede Person als eigenes Objekt simuliert wird. Entsprechend der Situation wirken nun virtuelle Kräfte auf diese Objekte, so verhindert eine virtuelle Abstoßungskraft zwischen zwei Personen, dass diese zusammenstoßen. Die betrachtete Simulation wird durch eine Vielzahl von Parametern konfiguriert, die mit realen Experimenten kalibriert werden müssen. Dies kann durch eine Optimierung der Parameter gelöst werden, die die Simulation den Experimenten möglichst weitgehend annähert. Literatur und Zusatzinformationen

| |||||||||||||||||||

| 15 Jan 2015 | Geometrische Analysis | 00:41:35 | |||||||||||||||||